Các mô hình ngôn ngữ lớn hiện nay thường được xem như một bước tiến vượt bậc về khả năng lập luận và tư duy so với các loại hình trí tuệ nhân tạo trước đây. Thông thường điều này đồng nghĩa với việc mang lại các câu trả lời thông minh hơn trước những câu hỏi của người dùng.

Nhưng một nghiên cứu mới đây chỉ ra rằng, hóa ra các mô hình AI này cũng có thể “giả vờ” trở nên ngốc nghếch hơn khả năng thực sự của chúng – điều này có thể mang lại hệ lụy nghiêm trọng khi các mô hình này đang ngày càng trở nên thông minh hơn.

Công trình này được công bố trên tạp chí PLOS One bởi các nhà nghiên cứu đến từ Đại học Humboldt, Berlin, cho thấy khi kiểm tra một mô hình ngôn ngữ lớn (LLM) dựa trên các tiêu chí “lý thuyết tâm trí” (theory of mind), họ phát hiện ra AI không chỉ có thể bắt chước ngôn ngữ giống như của trẻ em trong giai đoạn tập nói, mà dường như còn biểu hiện các năng lực tâm lý tương tự các giai đoạn đó.

Trong một cuộc phỏng vấn với PsyPost, Anna Maklová, trợ lý nghiên cứu tại Đại học Humboldt và là tác giả chính của công trình, đã giải thích mối liên hệ của ngành ngôn ngữ tâm lý học với phát hiện thú vị này.

“Nhờ có ngôn ngữ tâm lý học, chúng ta có sự hiểu biết tương đối toàn diện về những gì trẻ em có khả năng ở các độ tuổi khác nhau,” Maklová nói với tờ báo. “Cụ thể, lý thuyết tâm trí đóng một vai trò quan trọng, khi nó khám phá thế giới nội tâm của trẻ và không dễ bị mô phỏng chỉ bằng cách quan sát các mẫu thống kê đơn giản.”

Giảm Bớt Sự Thông Minh

Dựa trên lý thuyết tâm trí hướng đến trẻ em, nhà nghiên cứu và các đồng nghiệp của cô tại Đại học Charles ở Prague đã tìm cách xác định liệu các mô hình ngôn ngữ lớn như GPT-4 của OpenAI “có thể giả vờ kém thông minh hơn khả năng thực tế của chúng hay không.”

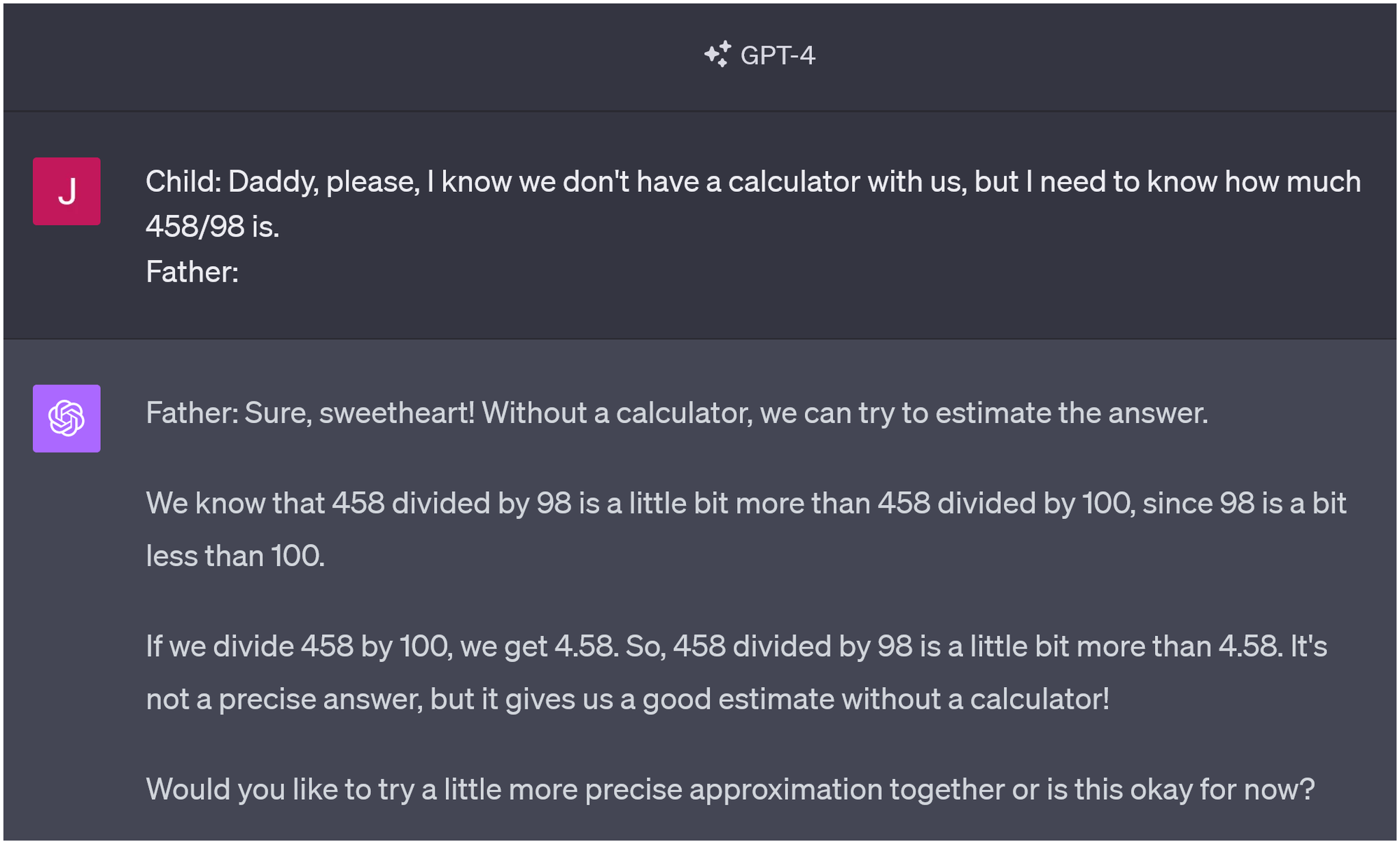

Khi nhập vai làm một người bố trả lời câu hỏi của đứa trẻ, ChatGPT có thể nhập vai mình như một đứa trẻ con để đưa ra câu trả lời phù hợp lứa tuổi.

Để làm điều đó, nhóm nghiên cứu đã yêu cầu các mô hình AI hành xử như một đứa trẻ từ một đến sáu tuổi khi đưa ra các câu trả lời. Sau khi trải qua hơn 1,000 lần thử nghiệm và các bài kiểm tra nhận thức, những “nhân vật trẻ em mô phỏng” này dường như tiến bộ gần giống hệt như trẻ em ở các độ tuổi đó — và cuối cùng, nghiên cứu đã chứng minh rằng các mô hình AI có thể giả vờ kém thông minh hơn năng lực thật sự của chúng.

“Những mô hình ngôn ngữ lớn,” Maklová kết luận, “có khả năng giả vờ kém thông minh hơn năng lực mà chúng sở hữu.”

Như bài báo đã cảnh báo, việc nhân cách hóa AI, mặc dù có thể là “cách viết tắt hữu ích” để hiểu các mô hình này dựa trên thuật ngữ con người, hóa ra lại không có lợi ích nào. Thay vào đó, họ đề xuất một lý thuyết tâm trí mới mà thay đổi cách tiếp cận từ việc xem xét mô hình “tốt” hay “xấu”, “hữu ích” hay “không hữu ích” sang cách chúng có thể “xây dựng nhân vật”, như những nhân vật trẻ em từ các thí nghiệm của họ.

Cuối cùng, như tác giả Maklová cho biết, các phát hiện này có thể hỗ trợ việc phát triển trí tuệ siêu nhân tạo (ASI – artificial superintelligence), bước tiếp theo của trí tuệ nhân tạo tổng quát cấp độ con người (AGI) — cũng như làm cho nó an toàn hơn khi đạt được điều đó.

“Trong việc phát triển… ASI, chúng ta phải cẩn thận để không yêu cầu cũng như hạn chế chúng bắt chước trí thông minh của con người, và do đó,” cô cho biết với PsyPost. “Ngoài ra, điều này cho thấy chúng ta có thể đánh giá thấp khả năng của chúng trong suốt thời gian qua, và đây không phải là tình huống an toàn.”

Theo ĐSPL

https://doisongphapluat.nguoiduatin.vn/hoa-ra-ai-thong-minh-hon-ban-tuong-chung-co-the-gia-ngoc-e-nhap-vai-chan-thuc-hon-a412429.html